Hier werden aktuelle Publikationen und Ergebnisse des Konsortiums und der assoziierten Mitglieder des Research Hub Neuroethics im Bereich Neuroethik aufgelistet.

Dieses Buch bietet einen umfassenden Überblick über aktuelle Themen der Entscheidungsfindung. Es behandelt neue Erkenntnisse zu Grundlagen, Mechanismen und Folgen von Entscheidungen und beleuchtet die kognitiven Prozesse aus verschiedenen disziplinären Perspektiven. Die Kapitel berichten über psychologische Studien zu den kognitiven Mechanismen der Entscheidungsfindung, Neuroimaging-Studien zu den neuronalen Korrelaten, Studien an Patient*innengruppen zur Charakterisierung von Veränderungen in der Entscheidungsfindung bei bestimmten Krankheiten sowie Diskussionen zu philosophischen und ethischen Fragen.

In den jüngsten Debatten über digitale Zwillinge wurde viel Aufmerksamkeit darauf verwendet, die Interaktion zwischen Individuen und ihren digitalen Repräsentationen zu verstehen (Braun, Citation2021). Iglesias et al. (Citation2025) werfen ein neues Licht auf diese Debatte und erweitern die Reflexion über digitale Doppelgänger – digitale Zwillinge, die versuchen, die psychologische Dimension eines Individuums nachzubilden. Sie argumentieren, dass solche Kopien als wertvolles Mittel dienen können, um Vermächtnisse und relationale Ziele zu erreichen, die aufgrund des Todes der Person unerfüllt geblieben sind. Vor diesem Hintergrund diskutieren wir, inwieweit wir die implizierten normativen Aspekte besser verstehen können, wenn wir sie im Zusammenhang mit dem Tod der dargestellten Person betrachten. Konkret fragen wir, wie wir normativ gesehen mit einem digitalen Zwilling als Repräsentation einer Person nach deren Tod umgehen können und sollten.

Hier betrachten wir die Stilllegung solcher Technologien. Wir definieren Stilllegung als die Rücknahme, Demontage oder Unbrauchbarmachung des Doppelgängers für seine ursprünglichen Zwecke. Wir stellen die Hypothese auf, dass die Art und Weise, wie diese digitalen Doppelgänger außer Betrieb genommen werden sollten, davon abhängen könnte, ob sie als Stellvertreter oder als Erweiterung der Persönlichkeit betrachtet werden. Mit Stellvertreter meinen wir einen Ersatz für eine Person, der deren Entscheidungen und Stil nachahmt, ohne deren persönliche Identität oder subjektive Erfahrung zu verkörpern; etwas, das Entscheidungen in Ihrem Namen trifft, aber nicht Sie selbst ist (Braun und Krutzinna, Zitat 2022). Was zurückbleibt, ist vergleichbar mit einem Artefakt, das Ihnen gehört. Eine Erweiterung der Persönlichkeit hingegen kann bedeuten, Aspekte der Identität und relationalen Präsenz einer Person über den Tod hinaus zu verlängern, indem ihre Werte, Projekte und Beziehungen widergespiegelt werden; etwas, das ein Teil von Ihnen ist/war. Was zurückbleibt, ist vergleichbar mit einer „Informationsleiche” (Öhman und Floridi, Zitat 2018).

Die Beantwortung dieser Frage zur Stilllegung ist nicht nur notwendig, um die beabsichtigten Ziele derjenigen zu respektieren, für die die digitalen Doppelgänger geschaffen wurden, sondern auch, um bestimmte soziale Normen im Zusammenhang mit Begräbnissen zu respektieren. Die Betrachtung digitaler Doppelgänger als Stellvertreter oder Erweiterungen der Persönlichkeit impliziert entsprechende normative Vorstellungen. So erfordert beispielsweise die Verfolgung einer Stilllegungsstrategie notwendige und ausreichende Standards für eine informierte Einwilligung, die möglicherweise schwer zu analysieren sind, da nicht alle Personen ihren digitalen Doppelgänger auf die gleiche Weise betrachten. Die Stilllegung digitaler Doppelgänger wird somit durch moralische Nuancen bereichert, die von unserer Wahrnehmung dieser Technologie beeinflusst werden.

Die Optogenetik birgt Potenzial für die Behandlung von Retinitis pigmentosa und anderen seltenen, degenerativen Netzhauterkrankungen. Mithilfe dieser Technologie, die Gentechnik und optische Stimulation mit Licht kombiniert, ist eine Steuerung der Zellaktivität möglich. Erste klinische Studien werden bereits durchgeführt. Dabei konnte das Sehvermögen der teilnehmenden Patient*innen, die durch Retinitis pigmentosa erblindet waren, teilweise wiederhergestellt werden. Angesichts des laufenden Translationsprozesses untersucht dieser Artikel die regulatorischen Aspekte der präklinischen und klinischen Forschung sowie der therapeutischen Anwendung der Optogenetik in der Augenheilkunde. In der Europäischen Union gibt es weder ein Verbot noch spezifische Vorschriften für optogenetische Methoden. In der präklinischen Forschung sind rechtliche Fragen im Zusammenhang mit Tierversuchen und der Stammzellenforschung von Bedeutung. In der klinischen Forschung und bei therapeutischen Anwendungen sind Aspekte der Autonomie von Proband*innen und Patient*innen relevant. Da es auf EU-Ebene bislang keine spezifischen Vorschriften für kombinierte Studien gibt, in denen ein Arzneimittel und ein Medizinprodukt gleichzeitig bewertet werden, gelten die Anforderungen für klinische Prüfungen mit Arzneimitteln sowie die Anforderungen für klinische Untersuchungen mit Medizinprodukten. Dies wirft ungelöste rechtliche Fragen auf, die insbesondere für optogenetische klinische Studien relevant sind, bei denen gleichzeitig ein als Gentherapeutikum (GTMP) klassifizierter viraler Vektor für den Gentransfer und ein als Medizinprodukt qualifiziertes Gerät für die Lichtstimulation getestet werden. Arzneimittel für optogenetische Therapien der Retinitis pigmentosa erfüllen die Anforderungen für die Einstufung als Orphan-Arzneimittel, was mit regulatorischen und finanziellen Anreizen einhergeht. Für Medizinprodukte für seltene Krankheiten gibt es jedoch keine gleichwertige Regelung.

Virtual Reality (VR) führt zu einer radikalen psychologischen Neuorientierung. Beschreibungen dieser Neuorientierung sind jedoch oft mit theoretisch irreführenden Metaphern durchsetzt. Wir bieten eine ausgewogenere Darstellung, die sowohl auf Philosophie als auch auf kognitiver Psychologie basiert. Mithilfe dieser Darstellung bewerten wir die Behauptung, dass VR das moralische Lernen durch die Stimulation der Perspektive Anderer fördert. Diese Hypothese basiert auf der Annahme, dass die Verwendung von Avataren Erfahrungen hervorruft, die denen anderer Menschen ähnlich genug sind, um empathisches Wachstum zu ermöglichen. Wir lehnen diese Annahme ab und führen zwei Argumente dagegen an. Empathie, die für moralisches Lernen relevant ist, erfordert interpretative Anstrengungen und kontextuelles Verstehen und geht somit über einen reinen Perspektivwechsel hinaus. Zudem neigt die offene, benutzer*innengesteuerte Struktur der VR dazu, vorherige Annahmen zu verstärken, anstatt sie zu erschüttern. Dennoch kann die Verwendung von Avataren einen anderen Effekt auf das moralische Lernen haben, den wir als Selbstfragmentierung bezeichnen. Durch die Aufweichung der Grenzen des Selbst kann VR den Kreis der Menschen, denen man sich empathisch zugewandt fühlt, erweitern.

Der Band konzentriert sich auf die ethischen Dimensionen des technologischen Gerüsts, in das menschliches Denken und Handeln eingebettet ist und das durch die Theorien der situierten Kognition ins Blickfeld der Kognitionswissenschaften gerückt wurde. Es gibt ein breites Spektrum von Technologien, die menschliches Erkennen und Handeln mitverwirklichen oder ermöglichen und verstärken und die sich im Grad der körperlichen Integration, der Interaktivität, der Anpassungsprozesse, der Abhängigkeit und Unentbehrlichkeit usw. unterscheiden. Dieses technologische Gerüst des menschlichen Erkennens und Handelns entwickelt sich rasch weiter. Einige Veränderungen sind kontinuierlich, andere sind eruptiv. Technologien, die z. B. maschinelles Lernen nutzen, könnten einen qualitativen Sprung im technologischen Gerüst menschlicher Wahrnehmung und Handlungen darstellen. Die ethischen Konsequenzen der Anwendung von Theorien der situierten Kognition auf praktische Fälle haben bisher noch keine angemessene Aufmerksamkeit gefunden und werden in diesem Band erläutert.

Das maschinelle Lernen (ML) hat die Fähigkeiten von Robotern erheblich verbessert und sie in die Lage versetzt, eine breite Palette von Aufgaben in menschlicher Umgebung auszuführen und sich an unsere unsichere reale Welt anzupassen. Jüngste Arbeiten in verschiedenen Bereichen des maschinellen Lernens haben deutlich gemacht, wie wichtig die Berücksichtigung von Fairness ist, um sicherzustellen, dass diese Algorithmen nicht menschliche Vorurteile reproduzieren und folglich zu diskriminierenden Ergebnissen führen. Da lernende Robotersysteme immer mehr Aufgaben in unserem Alltag übernehmen, ist es wichtig, den Einfluss solcher Vorurteile zu verstehen, um unbeabsichtigtes Verhalten gegenüber bestimmten Personengruppen zu verhindern. In dieser Arbeit präsentieren wir die erste Übersicht über Fairness beim Roboterlernen aus einer interdisziplinären Perspektive, die technische, ethische und rechtliche Herausforderungen umfasst. Wir schlagen eine Taxonomie für Quellen der Voreingenommenheit und die daraus resultierenden Arten der Diskriminierung vor. Anhand von Beispielen aus verschiedenen Bereichen des Roboterlernens untersuchen wir Szenarien unfairer Ergebnisse und Strategien zu deren Abmilderung. Wir stellen erste Fortschritte auf diesem Gebiet vor, indem wir verschiedene Fairness-Definitionen, ethische und rechtliche Überlegungen sowie Methoden für faires Roboterlernen behandeln. Mit dieser Arbeit wollen wir den Weg für bahnbrechende Entwicklungen im Bereich des fairen Roboterlernens ebnen.

Die Digitalisierung in den Lebenswissenschaften hat im Hinblick auf das Dual-Use-Problem zwei voneinander unterscheidbare Einflüsse, nämlich einen verschärfenden und einen erweiternden. Dadurch, dass die Digitalisierung schnellere und umfangreichere Forschungs- und Entwicklungsprozesse ermöglicht, verschärft sie das bestehende Dual-Use-Problem, weil zugleich das Tempo steigt, in dem die Ergebnisse dieser Forschung für sicherheitsrelevante Zwecke nutzbar gemacht werden können. Zudem erweitert die Digitalisierung der Lebenswissenschaften das Dual-Use-Problem, denn einige der digitalen Werkzeuge, die in den Lebenswissenschaften entwickelt und gebraucht werden, können selbst militärische oder sicherheitsrelevante Verwendung finden.

Deshalb bedarf es einer breit angelegten Governance inklusive einer breiten Beteiligung der Stakeholder im Forschungsprozess und eines Informationsangebots zu Dual Use in der Ausbildung in guter wissenschaftlicher Praxis über Institutionen, Karrierestufen und Disziplinen hinweg.

Phänomenologische Interviewmethoden (PIMs) sind zu wichtigen Instrumenten für die Untersuchung subjektiver, persönlicher Berichte über die neuartigen Erfahrungen von Menschen geworden, die Neurotechnologien nutzen. Durch die tiefe Erforschung persönlicher Erfahrungen helfen PIMs, sowohl die gemeinsamen Strukturen als auch bemerkenswerte Unterschiede zwischen den Erfahrungen aufzudecken. Die phänomenologischen Methoden unterscheiden sich jedoch darin, welche Aspekte der Erfahrung sie zu erfassen versuchen und was sie möglicherweise übersehen. Ein Großteil der Diskussion über phänomenologische Methoden ist in der philosophischen und breiteren bioethischen Literatur geblieben. Hier beginnen wir mit einer konzeptionellen Einführung und einem vorläufigen Leitfaden für die Anwendung phänomenologischer Methoden zur Untersuchung der Erfahrungen von Nutzern neuronaler Geräte.

Um die Methodik der phänomenologischen Befragung zu verbessern und zu erweitern, insbesondere im Zusammenhang mit den Erfahrungen von Nutzern neuronaler Geräte, geben wir zunächst einen kurzen Überblick über drei verschiedene PIMs, um ihre Merkmale und Unzulänglichkeiten aufzuzeigen. Anschließend plädieren wir für eine kritische Phänomenologie - in Ablehnung des „neutralen“ phänomenologischen Subjekts -, die zeitliche und ökologische Aspekte der beteiligten Subjekte, einschließlich des Interviewers und der Interviewerin (z. B. Alter, Geschlecht, soziale Situation, körperliche Konstitution, Sprachkenntnisse, mögliche kognitive krankheitsbedingte Beeinträchtigungen, traumatische Erinnerungen) sowie deren Bezogenheit einbezieht, um eine eingebettete und situierte Befragung zu gewährleisten. Unserer Ansicht nach müssen PIMs auf einer Konzeption von Erfahrung beruhen, die die relationalen und situierten sowie die anthropologischen, politischen und normativen Dimensionen der verkörperten Kognition einschließt und betont.

Wir stützen uns auf die kritische Phänomenologie und die traumainformierte qualitative Arbeit, um für einen ethisch sensiblen Interviewprozess aus einer angewandten phänomenologischen Perspektive zu argumentieren. Auf der Grundlage dieser Ansätze zur Verfeinerung der PIMs können Forscher bei der Erforschung der Beziehung des Befragten zu seiner Neuroprothese sensibler vorgehen und die Beziehung zwischen Interviewer und Befragtem sowohl auf zwischenmenschlicher als auch auf sozialer Ebene berücksichtigen.

Dieser Aufsatz untersucht das Potenzial von gemeinschaftsgeführter partizipativer Forschung für die Wertorientierung bei der Entwicklung medizinischer KI-Systeme. Zunächst werden konzeptionelle Aspekte von Partizipation und Teilhabe, die aktuellen Paradigmen der KI-Entwicklung in der Medizin und die neuen Herausforderungen der KI-Technologien untersucht. Der Aufsatz schlägt einen Wandel hin zu einem stärker partizipativen und gemeinschaftsgeleiteten Ansatz bei der KI-Entwicklung vor, der durch verschiedene partizipative Forschungsmethoden in den Sozialwissenschaften und Design Thinking veranschaulicht wird. Er erörtert die vorherrschenden Paradigmen der Ethik durch Gestaltung und der eingebetteten Ethik bei der Wertanpassung medizinischer Technologien und räumt deren Grenzen und Kritikpunkte ein. Anschließend wird ein Modell für die gemeinschaftsgeleitete Entwicklung von KI in der Medizin vorgestellt, das die Bedeutung der Einbeziehung von Gemeinschaften in allen Phasen des Forschungsprozesses hervorhebt. Der Aufsatz plädiert für einen Wandel hin zu einem stärker partizipativen und gemeinschaftsgeleiteten Ansatz bei der KI-Entwicklung in der Medizin, der effektivere und ethischere medizinische KI-Systeme verspricht.

Neuere Arbeiten zu ökologischen Konzepten der moralischen Verantwortung und des Handelns haben die Bedeutung des sozialen Umfelds für die Empfänglichkeit für moralische Gründe hervorgehoben. Das moralische Publikum kann die Sensibilität der einzelnen Akteure für moralische Gründe und ihre Motivation, danach zu handeln, fördern, aber auch untergraben. In diesem Beitrag betrachten wir zwei Fallstudien, in denen moralisches Handeln durch das soziale Umfeld unterminiert wird: Straßengangs und Online-Incel-Communities. Bei der Erörterung dieser Fallstudien stützen wir uns sowohl auf die neuere Literatur zur situierten Kognition als auch auf die Theorie der gerüsteten Verantwortung. Wir zeigen, dass die Art und Weise, wie Individuen in ein bestimmtes soziales Umfeld eingebettet sind, die moralischen Erwägungen, für die sie empfänglich sind, auf systematische Weise verändert, und zwar aufgrund der Art und Weise, wie dieses Umfeld affektive und kognitive Prozesse unterstützt, insbesondere solche, die die Wahrnehmung und Behandlung von Ingroups und Outgroups betreffen. Wir argumentieren, dass Gangs die Sensibilität für Gründe in größerem Maße untergraben als Incel-Gemeinschaften, weil Gang-Mitglieder gründlicher in das Gang-Umfeld eingebettet sind.

Eine vertrauenswürdige medizinische KI erfordert Transparenz über die Entwicklung und Prüfung der zugrunde liegenden Algorithmen, um Verzerrungen zu erkennen und potenzielle Schadensrisiken zu kommunizieren. Es gibt zahlreiche Anleitungen zur Erreichung von Transparenz bei medizinischen KI-Produkten, aber es ist unklar, ob öffentlich verfügbare Informationen angemessen über ihre Risiken informieren. Um dies zu beurteilen, haben wir öffentliche Unterlagen zu den 14 in den EU verfügbaren CE-zertifizierten KI-basierten Radiologieprodukten der Risikokategorie II b von den Websites der Hersteller, aus wissenschaftlichen Veröffentlichungen und aus der europäischen Datenbank EUDAMED abgerufen. Mithilfe einer selbst entworfenen Umfrage berichteten wir über deren Entwicklung, Validierung, ethische Erwägungen und Vorbehalte bei der Anwendung gemäß den vertrauenswürdigen KI-Richtlinien. Wir bewerteten jede Frage entweder mit 0, 0,5 oder 1, um zu beurteilen, ob die erforderlichen Informationen „nicht verfügbar“, „teilweise verfügbar“ oder „vollständig verfügbar“ waren. Die Transparenz der einzelnen Produkte wurde im Verhältnis zu allen 55 Fragen berechnet. Die Transparenzwerte reichten von 6,4 % bis 60,9 %, mit einem Mittelwert von 29,1 %. Zu den größten Transparenzlücken gehörten fehlende Unterlagen zu Schulungsdaten, ethischen Erwägungen und Einsatzbeschränkungen. Ethische Aspekte wie Einwilligung, Sicherheitsüberwachung und GDPR-Konformität waren nur selten dokumentiert. Darüber hinaus gab es kaum Vorbehalte zum Einsatz in verschiedenen demografischen und medizinischen Bereichen. Zusammenfassend lässt sich sagen, dass die öffentliche Dokumentation von zugelassenen medizinischen KI-Produkten in Europa nicht ausreichend transparent ist, um über Sicherheit und Risiken zu informieren. Wir fordern den Gesetzgeber und die Regulierungsbehörden auf, gesetzlich vorgeschriebene Anforderungen an die öffentliche und inhaltliche Transparenz festzulegen, um das Versprechen einer vertrauenswürdigen KI für die Gesundheit zu erfüllen.

Der Begriff der Autonomie ist in der Geschichte des westlichen Denkens unverzichtbar. Zumindest erscheint er uns heute so. Allerdings hatte der Begriff nicht immer die herausragende Bedeutung, die wir ihm heute zuschreiben, und auch seine genaue Bedeutung hat sich im Laufe der Zeit erheblich verändert. In diesem Beitrag wollen wir die unterschiedlichen Auffassungen von Autonomie beleuchten und klar voneinander abgrenzen. Unser Hauptziel ist es, einen Beitrag zur begrifflichen Klarheit im (interdisziplinären) Diskurs zu leisten und auf mögliche Fallstricke des Begriffspluralismus hinzuweisen.

Die Debatte über Vorhersage und Erklärbarkeit in der künstlichen Intelligenz (KI) dreht sich um den Zielkonflikt zwischen der Erzielung leistungsstarker und genauer Modelle und der Fähigkeit, den Entscheidungsprozess dieser Modelle zu verstehen und zu interpretieren. In den letzten Jahren hat diese Debatte aufgrund des zunehmenden Einsatzes von KI-Systemen in verschiedenen Bereichen wie dem Gesundheitswesen, dem Finanzwesen und der Strafjustiz stark an Aufmerksamkeit gewonnen. Während Vorhersage und Erklärbarkeit prinzipiell wünschenswerte Ziele sind, hat die jüngste Verbreitung von Algorithmen des maschinellen Lernens (ML) mit hoher Genauigkeit und dennoch undurchsichtiger Struktur den Zielkonflikt zwischen beiden hervorgehoben und diese Debatte zu einem interdisziplinären und interprofessionellen Schauplatz für die Aushandlung von Fachwissen gemacht. Es gibt keine Einigung mehr darüber, was das „Standard“-Gleichgewicht zwischen Vorhersage und Erklärbarkeit sein sollte, und die verschiedenen Positionen spiegeln die Ansprüche an die berufliche Zuständigkeit wider. Insgesamt scheint es eine wachsende Kluft zu geben zwischen der regulativen und ethisch begründeten Forderung nach Erklärbarkeit als Voraussetzung für vertrauenswürdige KI und der Art und Weise, wie sie gestaltet, aufgenommen und verhandelt wird. Der Anstoß zum Verfassen dieses Kommentars kommt von den jüngsten Vorschlägen, dass Erklärbarkeit überbewertet wird, einschließlich des Arguments, dass Erklärbarkeit auch bei menschlichen Gesundheitsexperten nicht garantiert ist. Um diese Debatte, ihre Prämissen und ihre jüngsten Wendungen zu erhellen, geben wir einen Überblick über die wichtigsten Argumente, die verschiedene Rahmen repräsentieren, und konzentrieren uns dabei auf KI im Gesundheitswesen.

Positionspapiere zur Ethik der künstlichen Intelligenz (KI) sind oft als Versuche formuliert, technische und regulatorische Strategien zu erarbeiten, um das zu erreichen, was gemeinhin als vertrauenswürdige KI bezeichnet wird. In solchen Papieren werden häufig die technischen und regulatorischen Strategien im Detail analysiert, nicht aber das Konzept der vertrauenswürdigen KI. Infolgedessen bleibt es unklar. In diesem Papier werden verschiedene mögliche Interpretationen des Konzepts dargelegt, und es wird festgestellt, dass keine davon angemessen ist. Das Hauptproblem besteht darin, dass wir, wenn wir die Ethik der KI mit Begriffen der Vertrauenswürdigkeit umschreiben, ungerechtfertigte anthropozentrische Annahmen verstärken, die einer klaren Analyse im Wege stehen. Selbst wenn wir auf einer rein epistemischen Interpretation des Konzepts bestehen, wonach Vertrauenswürdigkeit lediglich messbare Zuverlässigkeit bedeutet, zeigt sich, dass die Analyse dennoch unter einer subtilen Form des Anthropozentrismus leidet. Im Folgenden wird das Konzept des seltsamen Irrtums entwickelt, das dazu dient, sowohl die anfängliche Diagnose der Unzulänglichkeit vertrauenswürdiger KI zu schärfen als auch die neuartige erkenntnistheoretische Situation zu formulieren, die durch den Einsatz von KI entsteht. Der Beitrag schließt mit einer Diskussion darüber, wie der seltsame Irrtum Druck auf die üblichen Praktiken der Beurteilung moralischer Schuld ausübt, insbesondere im Kontext der Medizin.

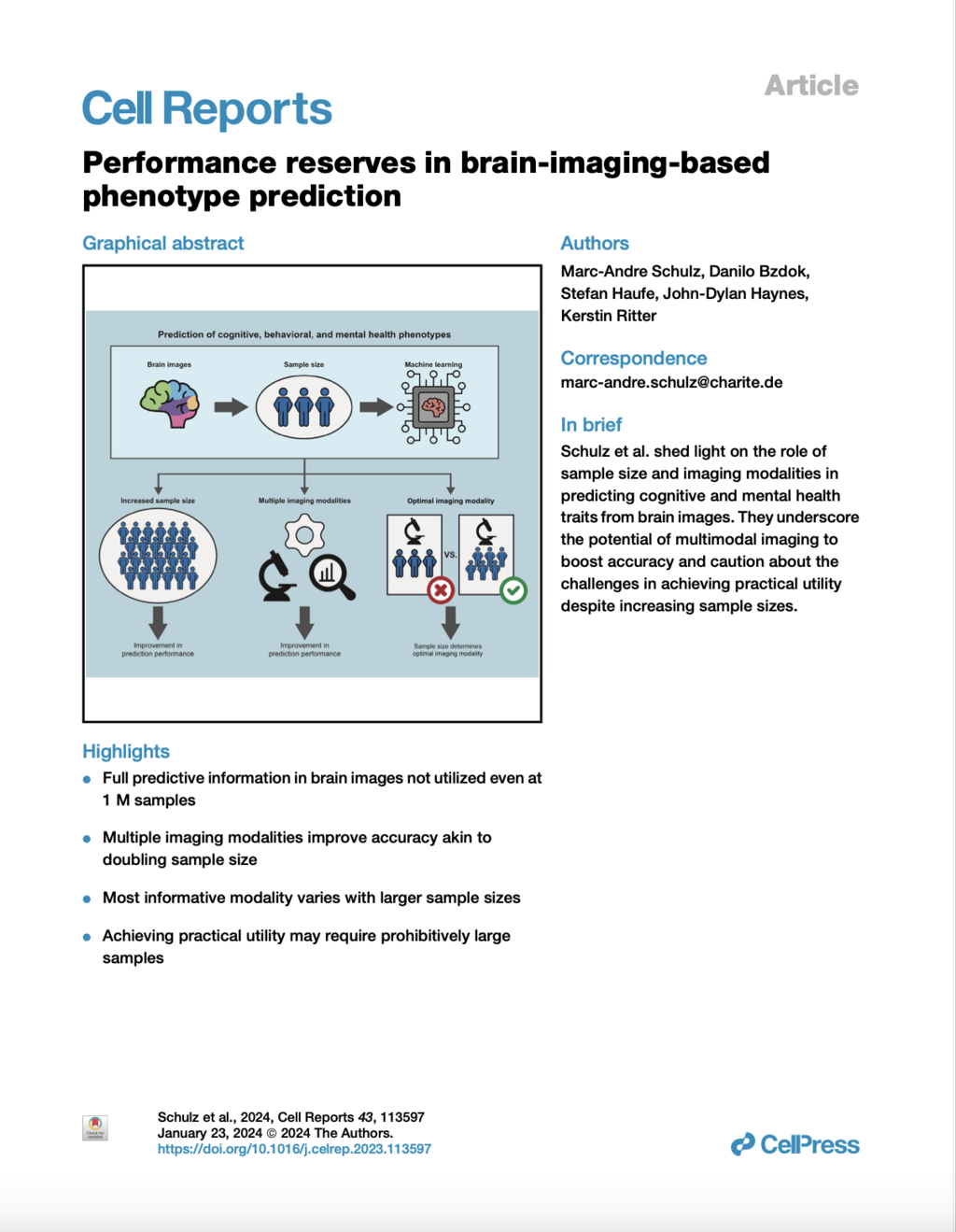

In dieser Studie werden die Auswirkungen der Stichprobengröße auf die Vorhersage von Phänotypen der kognitiven und psychischen Gesundheit anhand der Bildgebung des Gehirns durch maschinelles Lernen untersucht. Unsere Analyse zeigt eine 3- bis 9-fache Verbesserung der Vorhersageleistung, wenn die Stichprobengröße von 1.000 auf 1 Mio. Teilnehmer steigt. Trotz dieses Anstiegs deuten die Daten jedoch darauf hin, dass die Vorhersagegenauigkeit nach wie vor besorgniserregend niedrig ist und das Vorhersagepotenzial der Bildgebungsdaten des Gehirns bei weitem nicht ausgeschöpft wird. Darüber hinaus stellen wir fest, dass die Integration mehrerer Bildgebungsmodalitäten die Vorhersagegenauigkeit erhöht, was oft einer Verdoppelung der Stichprobengröße entspricht. Interessanterweise variierte die aussagekräftigste Bildgebungsmodalität oft mit zunehmender Stichprobengröße, was die Notwendigkeit unterstreicht, mehrere Modalitäten zu berücksichtigen. Trotz signifikanter Leistungsreserven bei der Vorhersage von Phänotypen kann das Erreichen substanzieller Verbesserungen eine prohibitiv große Stichprobengröße erfordern, was den praktischen oder klinischen Nutzen des maschinellen Lernens in einigen Bereichen der Neurobildgebung in Frage stellt.

Deep Learning (DL) hat sich als leistungsfähiges Werkzeug in der Neuroimaging-Forschung erwiesen. DL-Modelle, die Hirnpathologien, psychologische Verhaltensweisen und kognitive Eigenschaften aus Neuroimaging-Daten vorhersagen, haben das Potenzial, die neurobiologische Grundlage dieser Phänotypen zu entdecken. Diese Modelle können jedoch durch störende Bildgebungsartefakte oder durch die in den Neuroimaging-Daten kodierten Informationen über Alter und Geschlecht verfälscht werden. In dieser Studie stellen wir ein leichtgewichtiges und benutzerfreundliches Framework namens „DeepRepViz“ vor, das entwickelt wurde, um solche potenziellen Störfaktoren in DL-Modellvorhersagen zu erkennen und die Transparenz von prädiktiven DL-Modellen zu verbessern. DeepRepViz besteht aus zwei Komponenten - einem Online-Visualisierungstool (verfügbar unter https://deep-rep-viz.vercel.app/) und einer Metrik namens „Con-score“. Das Tool ermöglicht es Forschern, die endgültige latente Repräsentation ihres DL-Modells zu visualisieren und sie qualitativ auf Verzerrungen zu untersuchen. Der Con-Score oder die „Konzeptkodierung“ quantifiziert das Ausmaß, in dem potenzielle Störfaktoren wie Geschlecht oder Alter in der endgültigen latenten Repräsentation kodiert sind und die Modellvorhersagen beeinflussen. Wir veranschaulichen die Logik der Con-Score-Formulierung anhand eines Simulationsexperiments. Als nächstes demonstrieren wir den Nutzen des DeepRepViz-Rahmens, indem wir ihn auf drei typische Neuroimaging-basierte Vorhersageaufgaben anwenden (n = 12000). Dazu gehören (a) die Unterscheidung zwischen chronischen Alkoholkonsumenten und Kontrollpersonen, (b) die Klassifizierung des Geschlechts und (c) die Vorhersage der Geschwindigkeit bei der Bewältigung einer kognitiven Aufgabe, die als „Trail Making“ bekannt ist. Im DL-Modell zur Vorhersage von chronischem Alkoholkonsum zeigt DeepRepViz einen starken Einfluss des Geschlechts auf die Vorhersagen (Con-score = 0,35). In dem Modell zur Vorhersage der Leistung bei kognitiven Aufgaben zeigt DeepRepViz, dass das Alter eine große Rolle spielt (Con-score = 0,3). Das DeepRepViz-Framework ermöglicht es Neuroimaging-Forschern also, ihr Modell systematisch zu überprüfen und potenzielle Verzerrungen zu identifizieren, wodurch die Transparenz von prädiktiven DL-Modellen in Neuroimaging-Studien verbessert wird.

Unterschiedliche Formen von Hirnstimulation werden sowohl zur Therapie verschiedener neurologischer und psychiatrischer Krankheiten als auch zu Forschungszwecken verwendet. Im rechtswissenschaftlichen Diskurs fand bisher überwiegend die Tiefe-Hirnstimulation Beachtung. Dagegen mangelt es an Ausführungen zu Methoden der nicht-invasiven Hirnstimulation. Der Beitrag nimmt, vor dem Hintergrund des durch die Verordnung (EU) 2017/745 veränderten Rechtsrahmens, zunächst eine medizinprodukterechtliche Einordnung vor. Anschließend werden Fragen von Aufklärung und Einwilligung erläutert. Darüber hinaus werden rechtliche Aspekte der Verwendung von KI im Kontext von nicht-invasiver Hirnstimulation und Tiefer-Hirnstimulation dargestellt. Zum Abschluss erfolgt ein Ausblick auf die noch in der Entwicklung befindlichen Methoden der neuronalen Optogenetik.

Die Beiträge des Bandes untersuchen, inwiefern aktuelle Entwicklungen im Bereich der Künstlichen Intelligenz (KI) zu neuartigen Interaktionsprozessen führen und das Verhältnis von Menschen und Maschinen verändern. Dabei werden zunächst neue Entwicklungen von KI-basierten Technologien in diversen Anwendungs- und Entwicklungsbereichen vorgestellt. Hieran anschließend diskutieren ausgewiesene Expert:innen neuartige Mensch-Maschine-Interaktionen aus unterschiedlichen disziplinären Perspektiven und befragen diese auf ihre sozialen, ethischen und epistemologischen Implikationen. Der Band begreift sich als interdisziplinärer Beitrag zu der soziopolitisch drängenden Frage, wie die aktuellen technologischen Veränderungen Mensch-Maschine-Verhältnisse verändern und welche Konsequenzen dies für ein Denken von Mensch und Technik hat.

Werden Neurowissenschaftler dank der bildgebenden Verfahren des Gehirns bald Gedanken lesen können? Wir können diese Frage nicht beantworten, ohne den Stand der Technik in der Neurobildgebung zu kennen. Aber wir können diese Frage auch nicht beantworten, ohne ein gewisses Verständnis des Konzepts zu haben, auf das sich der Begriff „Gedankenlesen“ bezieht. Dieser Artikel ist ein Versuch, ein solches Verständnis zu entwickeln. Unsere Analyse erfolgt in zwei Schritten. In der ersten Phase liefern wir eine kategorische Erklärung des Gedankenlesens. Die kategoriale Erklärung formuliert empirische Bedingungen, die erfüllt sein müssen, damit Gedankenlesen möglich ist. In der zweiten Phase entwickeln wir einen Maßstab für die Beurteilung der Leistungsfähigkeit von Experimenten zum Gedankenlesen. Die sich daraus ergebende Konzeption des Gedankenlesens trägt dazu bei, volkspsychologische Urteile darüber, was Gedankenlesen beinhalten muss, mit den Beschränkungen, die durch empirische Strategien zu seiner Erreichung auferlegt werden, in Einklang zu bringen.

Die Vorhersage des Hirnalters ist ein relativ neues Instrument in der Neuromedizin und den Neurowissenschaften. In der Forschung und in der klinischen Praxis findet sie vielfältige Verwendung als Marker für das biologische Alter, für den allgemeinen Gesundheitszustand des Gehirns und als Indikator für verschiedene hirnbedingte Störungen. Ihr Nutzen bei all diesen Aufgaben hängt davon ab, dass Ausreißer erkannt werden und somit das chronologische Alter nicht korrekt vorhergesagt werden kann. Der indikative Wert der Altersvorhersage ergibt sich aus der Lücke zwischen dem chronologischen Alter eines Gehirns und dem vorhergesagten Alter, der „Brain Age Gap“ (BAG). In diesem Artikel wird gezeigt, wie die klinische und wissenschaftliche Anwendung der Hirnaltersvorhersage die Zustände, auf die sie anspricht, stillschweigend pathologisiert. Es wird argumentiert, dass der stillschweigende Charakter dieser Umwandlung die Notwendigkeit ihrer expliziten Rechtfertigung verdeckt.

Der Aufstieg der Neurotechnologien, insbesondere in Kombination mit Methoden der künstlichen Intelligenz (KI) zur Analyse von Hirndaten, hat zu Bedenken hinsichtlich des Schutzes der geistigen Privatsphäre, der geistigen Integrität und der kognitiven Freiheit geführt, die in ethischen, rechtlichen und politischen Diskussionen häufig als „Neurorechte“ bezeichnet werden. Mehrere Staaten prüfen derzeit die Aufnahme von Neurorechten in ihren verfassungsrechtlichen Rahmen, und internationale Institutionen und Organisationen wie die UNESCO und der Europarat zeigen aktives Interesse an der Entwicklung internationaler Politik- und Governance-Richtlinien zu diesem Thema. In vielen Diskussionen über Neurorechte werden jedoch die philosophischen Annahmen, ethischen Bezugsrahmen und rechtlichen Auslegungen entweder nicht explizit gemacht oder stehen im Widerspruch zueinander. Das Ziel dieser multidisziplinären Arbeit ist es, konzeptionelle, ethische und rechtliche Grundlagen zu schaffen, die ein gemeinsames, minimalistisches konzeptionelles Verständnis von geistiger Privatsphäre, geistiger Integrität und kognitiver Freiheit ermöglichen, um wissenschaftliche, rechtliche und politische Diskussionen zu erleichtern.

Forscher in der angewandten Ethik und insbesondere in einigen Bereichen der Bioethik haben das Ziel, konkrete und angemessene Handlungsempfehlungen für moralisch relevante Situationen in der realen Welt zu entwickeln. Beim Übergang von abstrakteren Ebenen ethischer Argumentation zu solchen konkreten Empfehlungen scheint es jedoch möglich zu sein, selbst in Bezug auf ein und dasselbe normative Prinzip oder dieselbe Norm abweichende oder sogar widersprüchliche Handlungsempfehlungen für eine bestimmte Situation zu entwickeln. Dies kann den Eindruck erwecken, dass solche Empfehlungen willkürlich und damit nicht gut begründet wären. Vor diesem Hintergrund wollen wir zunächst zeigen, dass ethische Handlungsempfehlungen zwar in gewisser Weise kontingent, aber nicht willkürlich sind, wenn sie in geeigneter Weise entwickelt werden. Zu diesem Zweck untersuchen wir zwei Arten von Kontingenzen, die sich in der angewandten ethischen Argumentation ergeben, anhand von aktuellen Beispielen von Handlungsempfehlungen im Zusammenhang mit der COVID-19-Pandemie. Dabei beziehen wir uns auf ein dreistufiges Modell der ethischen Argumentation für Handlungsempfehlungen. Dies lässt jedoch die Frage offen, wie die angewandte Ethik mit kontingenten Handlungsempfehlungen umgehen kann. Daher analysieren wir in einem zweiten Schritt die Rolle von Brückenprinzipien für die Entwicklung ethisch angemessener Handlungsempfehlungen, d.h. von Prinzipien, die normative Ansprüche mit relevanten empirischen Informationen verbinden, um bestimmte Handlungsempfehlungen in einer gegebenen moralisch relevanten Situation zu rechtfertigen. Schließlich diskutieren wir einige Implikationen für die Argumentation und Berichterstattung in der empirisch informierten Ethik.

Künstliche Intelligenz (KI) ist ein leistungsstarkes Werkzeug für verschiedene Aufgaben im Gesundheitswesen. KI-Tools eignen sich zur Optimierung prädiktiver Modelle in der Medizin. Ethische Debatten über die Ausweitung der Vorhersagekraft medizinischer Modelle durch KI deuten darauf hin, dass zentrale Grundsätze der Medizinethik angepasst werden müssen. Dieser Artikel zeigt, dass eine gängige Interpretation des Prinzips der Gerechtigkeit im Gesundheitswesen angesichts der Auswirkungen von KI auf die Entscheidungsfindung geändert werden muss. Der prozedurale Gerechtigkeitsansatz, der durch Norman Daniels und James Sabins Konzept der Angemessenheit veranschaulicht wird, muss geändert werden, da er, wie die Forschung zur algorithmischen Fairness zeigt, nicht ausreichend auf die unterschiedlichen Auswirkungen scheinbar gerechter Prinzipien auf verschiedene Personengruppen reagiert. Dieselbe Forschungsrichtung bringt Methoden hervor, um unterschiedliche Auswirkungen zu quantifizieren und sie für eine Korrektur zugänglich zu machen. Um das Gerechtigkeitsprinzip zu verbessern, bedarf es also einer Kombination aus Verfahren zur Auswahl von Gerechtigkeitskriterien und -grundsätzen und der Verwendung von algorithmischen Instrumenten zur Messung der tatsächlichen Auswirkungen dieser Kriterien und Grundsätze. In diesem Artikel zeigt der Autor, dass algorithmische Werkzeuge nicht nur Fragen der Gerechtigkeit aufwerfen, sondern auch zu ihrer Entschärfung beitragen können, indem sie uns über die tatsächlichen Auswirkungen informieren, die bestimmte Verteilungsprinzipien und -kriterien haben würden.

Dieser Artikel setzt sich kritisch mit der Konzeptualisierung von Vertrauen in der ethischen Diskussion über künstliche Intelligenz (KI) im spezifischen Kontext von sozialen Robotern in der Pflege auseinander. Zunächst wird versucht zu definieren, inwiefern man von „sozialen“ Robotern sprechen kann und wie sich deren „soziale Affordanzen“ auf die menschliche Vertrauensbereitschaft in der Mensch-Roboter-Interaktion auswirken. Vor diesem Hintergrund untersuchen wir die Verwendung des Konzepts von „Vertrauen“ und „Vertrauenswürdigkeit“ im Hinblick auf die Leitlinien und Empfehlungen der Hochrangigen Expertengruppe für KI der Europäischen Union.

Im Zusammenhang mit der rasanten Digitalisierung und dem Aufkommen von Gesundheitstechnologien für Verbraucher sind neurotechnologische Geräte mit weiteren Hoffnungen, aber auch mit großen ethischen und rechtlichen Bedenken verbunden.

Maschinelles Lernen (ML) wird zunehmend zur Vorhersage der klinischen Verschlechterung von PatientInnen auf der Intensivstation (ICU) mittels Scoring-Systemen eingesetzt. Solche Algorithmen sind zwar vielversprechend, passen sich aber oft zu sehr an ihre Trainingskohorte an und schneiden in neuen Krankenhäusern schlechter ab. Daher ist die externe Validierung ein entscheidender - aber häufig übersehener - Schritt, um die Zuverlässigkeit der vorhergesagten Risikowerte festzustellen und sie in die klinische Praxis zu übertragen. Wir haben systematisch untersucht, wie regelmäßig eine externe Validierung von ML-basierten Risikoscores durchgeführt wird und wie sich ihre Leistung bei externen Daten verändert.

DIES IST EIN PREPRINT UND NOCH NICHT PEER-REVIEWED. Er berichtet über neue medizinische Forschung, die noch nicht ausgewertet wurde und daher nicht als Richtschnur für die klinische Praxis dienen sollte.

Anwendungen künstlicher Intelligenz (KI) halten Einzug in unseren Alltag. Im Bereich der Medizin geht es um die Optimierung von Diagnose und Therapie, die Nutzung von Gesundheits-Apps verschiedenster Couleur, die Bereitstellung von Instrumenten der personalisierten Medizin, die Möglichkeiten roboterassistierter Chirurgie, ein optimiertes Krankenhausdatenmanagement, oder die Entwicklung und Bereitstellung intelligenter Medizinprodukte. Aber handeltes sich bei diesen Konstellationen überhaupt um Beispiele künstlicher Intelligenz? Und was bedeutet „Intelligenz“ bzw. welche Bedingungen müssen erfüllt sein, um von „Intelligenz“ reden zu können? Diese Fragen werden je nach Kontext und disziplinärer Verankerung äußerst unterschiedlich beantwortet, sodass sich im Ergebnis ein denkbar weitreichender und facettenreicher Diskurs zeigt. Unumstritten ist hingegen der Befund, dass die Qualität und die Quantität der unter KI firmierenden Anwendungen zahlreiche rechtliche, ethische, soziale sowie naturwissenschaftliche Fragen aufwerfen, die bislang einer umfassenden Behandlung und befriedigender Lösungen harren. Während das Recht bei der Technikregulierung praktischen Entwicklungen meist hinterherhinkt, kommt es im Bereich der KI zu einem Paradigmenwechsel: Ende April2021 hat die Europäische Kommission einen Entwurf einer „Verordnung zur Festlegung harmonisierter Vorschriften für künstliche Intelligenz (Gesetz über künstliche Intelligenz) und zur Änderung bestimmter Rechtsakte der Union“ 2 vorgelegt (im Folgenden: VO-E). Die folgenden Ausführungen stellen den diesem Entwurf zugrunde liegenden Regelungsansatz sowie die sich daraus ergebenden zentralen Definitionen, Pflichtenkreise und Mechanismen vor. Im Interesse einer ganzheitlichen Betrachtung werden darüber hinaus ebenso ethische, medizinisch-naturwissenschaftliche und gesellschaftliche Betrachtungen angestellt.

Die fortschreitende Verwendung von Verfahren künstlicher Intelligenz provoziert die Frage, inwiefern bei deren ethischer Bewertung auf anthropologische Reflexionen und insbesondere auf ein Kriterium des menschlichen Maßes zurückgegriffen werden kann. Der Beitrag thematisiert das schwierige Verhältnis von Ethik und Natur und erkundet über die Auseinandersetzung mit maßgeblichen kritischen Herausforderungen die Spielräume für den ethischen Rückgriff auf anthropologische Argumente, wobei der Einsatz von künstlicher Intelligenz in der Medizin den Anwendungsbezug bildet.

Einleitung

Obwohl Klassifikatoren des maschinellen Lernens häufig zur Erkennung der Alzheimer-Krankheit (AD) auf der Grundlage von MRT-Strukturdaten des Gehirns verwendet wurden, ist eine mögliche Verzerrung in Bezug auf Geschlecht und Alter noch nicht berücksichtigt worden. Hier untersuchen wir einen hochmodernen Alzheimer-Klassifikator auf potenzielle geschlechts- und altersbedingte Verzerrungen, selbst im Falle ausgeglichener Trainingsdaten.

Methoden

Auf der Grundlage einer alters- und geschlechtsbalancierten Kohorte von 432 Probanden (306 gesunde Kontrollen, 126 Probanden mit AD) aus der ADNI-Datenbank haben wir ein neuronales Faltungsnetzwerk zur Erkennung von AD in MRT-Gehirnscans trainiert und zehn verschiedene zufällige Trainings-Validierungs-Test-Splits durchgeführt, um die Robustheit der Ergebnisse zu erhöhen. Die Klassifizierungsentscheidungen für einzelne Probanden wurden durch schichtweise Relevanzfortpflanzung erklärt.

Ergebnisse

Der Klassifikator schnitt bei Frauen deutlich besser ab (ausgewogene Genauigkeit) als bei Männern (). Bei den klinischen Alzheimer-Scores wurden keine signifikanten Unterschiede festgestellt, so dass eine unterschiedliche Schwere der Erkrankung als Ursache für den Leistungsunterschied ausgeschlossen werden kann. Die Analyse der Erklärungen ergab eine größere Varianz in den regionalen Hirnarealen bei männlichen Probanden im Vergleich zu weiblichen Probanden.

Diskussion

Die festgestellten geschlechtsspezifischen Unterschiede können nicht auf einen unausgewogenen Trainingsdatensatz zurückgeführt werden und weisen daher darauf hin, wie wichtig es ist, die Klassifikatorleistung in verschiedenen Bevölkerungsuntergruppen zu untersuchen und auszuweisen, um die Transparenz und die Fairness der Algorithmen zu erhöhen. Das Sammeln von mehr Daten, insbesondere von unterrepräsentierten Untergruppen, und die Ausgewogenheit des Datensatzes sind wichtig, garantieren aber nicht immer ein faires Ergebnis.

:Es werden zunehmend Ressourcen für Lösungen der künstlichen Intelligenz (KI) für medizinische Anwendungen aufgewendet, um die Diagnose, Behandlung und Prävention von Krankheiten zu verbessern. Während die Notwendigkeit der Transparenz und der Verringerung von Voreingenommenheit bei der Entwicklung von Daten und Algorithmen in früheren Studien behandelt wurde, ist wenig über das Wissen und die Wahrnehmung von Voreingenommenheit unter KI-Entwicklern bekannt.

:

Ziel dieser Studie war es, KI-Spezialisten im Gesundheitswesen zu befragen, um die Wahrnehmung von Voreingenommenheit in KI-Algorithmen für Anwendungen im Gesundheitswesen sowie ihr Bewusstsein und die Anwendung von Präventionsmaßnahmen zu untersuchen.

Hintergrund: Eine genaue Vorhersage der klinischen Ergebnisse bei einzelnen Patienten nach einem akuten Schlaganfall ist für Gesundheitsdienstleister von entscheidender Bedeutung, um Behandlungsstrategien zu optimieren und die weitere Versorgung der Patienten zu planen. Hier verwenden wir fortschrittliche Verfahren des maschinellen Lernens (ML), um die Vorhersage der funktionellen Erholung, der kognitiven Funktion, der Depression und der Sterblichkeit von Patienten mit erstmaligem ischämischem Schlaganfall systematisch zu vergleichen und die wichtigsten Prognosefaktoren zu identifizieren.

Der Einsatz Künstlicher Intelligenz (KI), d. h. algorithmischer Systeme, die eigenständig komplexe Probleme lösen können, wird absehbar eine bedeutsame Rolle in der klinischen wie pflegerischen Praxis spielen. In der klinischen Praxis sind teilweise schon jetzt KI-Systeme im Einsatz, die diagnostische und therapeutische Entscheidungen unterstützen oder prognostisch arbeiten. Schon seit einigen Jahren werden etwa Systeme zur diagnostischen Unterstützung in der Radiologie getestet und diskutiert (Wu et al. 2020; McKinney et al. 2020). Damit einhergeht die Hoffnung auf schnellere, effizientere und effektivere Diagnosen und Entscheidungen sowie neue Therapie- und Prognosemöglichkeiten, insbesondere in der Big Data-basierten Medizin (d. h. in medizinischen Bereichen, die auf die Verarbeitung großer Mengen komplexer und unstrukturierter Daten angewiesen sind). In der pflegerischen Praxis spielt KI v. a. im Zusammenhang mit dem Einsatz von Pflegerobotern wie Paro oder Pepper eine Rolle, die pflegebedürftige Personen eigenständig animieren, mit diesen kommunizieren oder bestimmte pflegerische Tätigkeiten übernehmen sollen (Bendel 2018).

Diesen Erwartungen gegenüber steht eine Reihe ethischer Bedenken, etwa hinsichtlich möglicher Auswirkungen eines zunehmenden Einsatzes KI-basierter Systeme auf die ärztliche und pflegerische Rolle oder das Ärzt:innen-Patient:innen-Verhältnis. Darüber hinaus werden Fragen des Datenschutzes ebenso diskutiert wie mögliche gesellschaftliche Implikationen. Einen weiteren Schwerpunkt in der Debatte bilden die möglichen ethischen Implikationen der mangelnden Erklärbarkeit bzw. Explizierbarkeit von Diagnosen, therapeutischen Entscheidungen sowie Prognosen durch KI-basierte Systeme und ihre Bedeutung für Patient:innen bzw. die Interaktion zwischen Mensch und Medizintechnologie im Allgemeinen. Mit Blick auf den Einsatz von Pflegerobotern steht im Fokus der Debatten, unter welchen Bedingungen solche Systeme als vertrauenswürdig gelten können bzw. wie ein im Sinne pflegebedürftiger Personen angemessener Einsatz aussehen kann.

Die skizzierten Erwartungen an den Einsatz KI-basierter Systeme in Medizin und Pflege, wie auch insbesondere die damit verbundenen ethischen Herausforderungen, werfen darüber hinaus eine Reihe von Rechtsfragen auf. Von besonderer Bedeutung sind dabei Fragen zivilrechtlicher Haftung sowie strafrechtlich relevanter Verantwortung im Kontext des Einsatzes von KI-basierten Systemen. Insofern eine angewandt-ethische Reflexion neuer technologischer Entwicklungen grundsätzlich auch den geltenden Rechtsrahmen bzw. hier auftretende Lücken und Herausforderungen berücksichtigen muss, erscheint eine Auseinandersetzung mit diesen Fragen auch mit Blick auf die ethische Analyse geboten.

Fortschritte in der Neurotechnologie und künstlichen Intelligenz (KI) ermöglichen beispiellose Einblicke in das menschliche Gehirn. Es gibt zunehmend Möglichkeiten, die Gehirnaktivität zu beeinflussen und zu messen. Diese Entwicklungen werfen vielschichtige ethische und rechtliche Fragen auf. Die BefürworterInnen von Neurorechten plädieren für die Einführung neuer Menschenrechte zum Schutz geistiger Prozesse und Gehirndaten. Dieser Artikel erörtert die Notwendigkeit und Vorteile der Einführung neuer Menschenrechte und konzentriert sich dabei auf das vorgeschlagene neue Menschenrecht auf geistige Selbstbestimmung und das Recht auf Gedankenfreiheit, wie es in Artikel 18 des Internationalen Pakts über bürgerliche und politische Rechte (IPBPR) und Artikel 9 der Europäischen Menschenrechtskonvention (EMRK) verankert ist. Ich argumentiere, dass das Recht auf Gedankenfreiheit kohärent so interpretiert werden kann, dass es einen umfassenden Schutz geistiger Prozesse und Gehirndaten bietet und somit eine normative Grundlage für den Einsatz von Neurotechnologien bietet. Darüber hinaus behaupte ich, dass eine sich weiterentwickelnde Interpretation des Rechts auf Gedankenfreiheit überzeugender ist als die Einführung eines neuen Menschenrechts auf geistige Selbstbestimmung.

Die neuronale Optogenetik ist eine Technik zur Steuerung der Aktivität von Neuronen mit Licht. Dies wird durch die künstliche Expression lichtempfindlicher Ionenkanäle in den Zielzellen erreicht. Mit optogenetischen Methoden können Zellen, die von Natur aus lichtunempfindlich sind, durch Beleuchtung lichtempfindlich und adressierbar gemacht und zeitlich und räumlich präzise gesteuert werden. Bislang war die Optogenetik in erster Linie ein Werkzeug der Grundlagenforschung, um das Gehirn besser zu verstehen. Erste Studien untersuchen jedoch bereits die Möglichkeit, die Optogenetik beim Menschen für zukünftige therapeutische Ansätze bei neuronalen Erkrankungen wie Parkinson, Epilepsie oder zur Förderung der Genesung nach einem Schlaganfall einzusetzen. Darüber hinaus wurden optogenetische Methoden bereits erfolgreich an einem Menschen in einem experimentellen Setting angewendet. Die neuronale Optogenetik wirft auch ethische und rechtliche Fragen auf, z. B. in Bezug auf Tierversuche und ihre Anwendung beim Menschen. Weitere ethische und rechtliche Fragen können sich ergeben, wenn optogenetische Methoden an zerebralen Organoiden untersucht werden. Für die erfolgreiche Übertragung der Optogenetik von der Grundlagenforschung in die medizinische Praxis müssen daher auch die ethischen und rechtlichen Fragen dieser Technologie geklärt werden, da offene ethische und rechtliche Fragen die Übertragung behindern können. Der Artikel gibt einen Überblick über die ethischen und rechtlichen Fragen, die durch die neuronale Optogenetik aufgeworfen werden. Darüber hinaus zeigt die Arbeit unter Berücksichtigung der technischen Voraussetzungen für die Übersetzung konsistente Ansätze zur Lösung dieser offenen Fragen auf. Die Arbeit zielt auch darauf ab, den interdisziplinären Dialog zwischen Wissenschaftler*innen und Ärzt*innen einerseits sowie Ethiker*innen und Jurist*innen andererseits zu unterstützen, um eine interdisziplinär koordinierte Umsetzung der neuronalen Optogenetik zu ermöglichen.

Die zunehmende Verfügbarkeit von Hirndaten innerhalb und außerhalb des biomedizinischen Bereichs in Verbindung mit der Anwendung von künstlicher Intelligenz (KI) auf die Hirndatenanalyse stellt eine Herausforderung für Ethik und Governance dar. Wir zeigen die besonderen ethischen Implikationen der Erfassung und Verarbeitung von Hirndaten auf und skizzieren einen mehrstufigen Governance-Rahmen. Dieser Rahmen zielt darauf ab, den Nutzen der erleichterten Erfassung und Weiterverarbeitung von Hirndaten für Wissenschaft und Medizin zu maximieren und gleichzeitig die Risiken zu minimieren und eine schädliche Nutzung zu verhindern. Der Rahmen besteht aus vier primären Bereichen für regulatorische Eingriffe: verbindliche Regulierung, Ethik und Soft Law, verantwortungsvolle Innovation und Menschenrechte.

In den letzten zehn Jahren hat sich die künstliche Intelligenz (KI) weltweit zu einer disruptiven Kraft entwickelt, die ein enormes Innovationspotenzial bietet, aber auch Gefahren und Risiken für den Einzelnen und die Gesellschaft, in der er lebt, mit sich bringt. Dieser Band befasst sich mit den drängendsten philosophischen, ethischen, rechtlichen und gesellschaftlichen Herausforderungen, die KI mit sich bringt. Autoren aus verschiedenen Disziplinen und Sektoren untersuchen die grundlegenden und normativen Aspekte verantwortungsvoller KI und liefern eine Grundlage für einen transdisziplinären Ansatz für verantwortungsvolle KI. Dieses Werk, das künftige Diskussionen zur Entwicklung verhältnismäßiger Ansätze für eine verantwortungsvolle KI-Governance fördern soll, wird es Wissenschaftlern und anderen Akteuren ermöglichen, normative Rahmenbedingungen für KI zu identifizieren, die es Gesellschaften, Staaten und der internationalen Gemeinschaft erlauben, das Potenzial für verantwortungsvolle Innovationen in diesem wichtigen Bereich zu erschließen. Dieses Buch ist auch als Open Access auf Cambridge Core verfügbar.

In diesem Kapitel erörtert Philipp Kellmeyer den Schutz der geistigen Privatsphäre und der geistigen Integrität in der Interaktion mit KI-basierter Neurotechnologie aus der Perspektive von Philosophie, Ethik, Neurowissenschaft und Psychologie. Der Autor argumentiert, dass geistige Privatsphäre und Integrität wichtige anthropologische Güter sind, die vor ungerechtfertigten Eingriffen geschützt werden müssen. Anschließend skizziert er die aktuelle wissenschaftliche Diskussion und politische Initiativen zu Neurorechten und vertritt die Position, dass die bestehenden Menschenrechte zwar ausreichende Rechtsinstrumente darstellen, aber ein Ansatz erforderlich ist, der diese Rechte einklagbar und justiziabel macht, um die psychische Privatsphäre und die psychische Integrität zu schützen, zum Beispiel durch die Verknüpfung von Grundrechten mit spezifisch angewandten Gesetzen.

Derzeit stehen besonders die epistemische Qualität von Algorithmen und ihre normativen Implikationen im Blickpunkt. Während in diesem Zusammenhang allgemeine Fragen der Gerechtigkeit angesprochen wurden, sind spezifische Fragen der epistemischen (Un-)Gerechtigkeit bisher vernachlässigt worden. Wir wollen diese Lücke schließen, indem wir einige potenzielle Implikationen der verhaltensintelligenten Neurotechnologie (B-INT) analysieren. Wir behaupten, dass B-INT eine Reihe von epistemischen Merkmalen aufweist, die das Potenzial für bestimmte epistemische Probleme mit sich bringen, die wiederum wahrscheinlich zu Fällen von epistemischer Ungerechtigkeit führen. Um diese Behauptung zu untermauern, werden wir zunächst die Terminologie und die Technologie hinter B-INT vorstellen und erläutern. Zweitens werden wir vier fiktive Szenarien für den Einsatz von B-INT vorstellen und eine Reihe von epistemischen Problemen aufzeigen, die auftreten könnten. Drittens werden wir deren Beziehung zum Konzept der epistemischen Gerechtigkeit sowie mögliche Beispiele dafür diskutieren. So werden wir einige wichtige und moralisch relevante Implikationen der epistemischen Eigenschaften von INT aufzeigen

Neuroenhancement hat die Verbesserung der mentalen Eigenschaften, Fähigkeiten und Leistung einer Person zum Gegenstand. Die verschiedenen Techniken des Neuroenhancement bieten neuartige Möglichkeiten der Verbesserung, bergen jedoch auch signifikante Gefahren. Neuroenhancement stellt folglich sowohl Personen als auch die Gesellschaft im Ganzen vor umfassende normative Herausforderungen. Der vorliegende Sachstandsbericht bietet einen konzisen Überblick über die gegenwärtige Neuroenhancement-Debatte. Definition, Techniken und Zwecke des Neuroenhancement werden erörtert und Argumente für und wider seine Anwendung auf personaler, interpersonaler sowie sozialpolitischer Ebene untersucht.

Technologische Selbstoptimierung ist gegenwärtig in aller Munde. Sie umfasst die Erforschung neuer Möglichkeiten im Hinblick auf Schönheitsoperationen, funktionale Implantologie, Gehirndoping oder die Verlängerung der Lebensspanne. Gegenüber vielen dieser technischen Mittel, die oft nicht legal verfügbar sind, bestehen erhebliche gesellschaftliche Vorbehalte. Jan-Hendrik Heinrichs und Markus Rüther plädieren bei ihrer ethischen Einschätzung für eine Differenzierung der Perspektive: Die Vorbehalte sind nämlich ihrer Meinung nach nicht geeignet, gesellschaftliche Ächtung oder gar verbindliche Verbote für alle zu begründen. Vielmehr habe die Freiheit zur Selbstgestaltung Vorrang, was jedoch nicht heißt, dass es für manche Bereiche nicht auch klare Regeln geben muss. Weil Selbstgestaltung aber nur frei sein kann, wenn sie informiert ist, argumentieren die Autoren für Regelungen, die von weitgehenden Informationspflichten statt von Verboten bestimmt sind. Aus einer individuellen Sichtheraus lassen sich zudem eine Reihe von moralischen Empfehlungen formulieren, die zwar nicht eingefordert werden können, aber einen ethischen Kompass bilden, um sich im Dickicht der ethischen Debatte an guten Gründen zu orientieren.

Mithilfe der Neurobildgebung können vielfältige Informationen über Vorgänge im menschlichen Gehirn gesammelt werden. Dieser Sachstandsbericht informiert über die Grundlagen und Einsatzmöglichkeiten von bildgebenden Verfahren in den Neurowissenschaften, beleuchtet einschlägige rechtliche Normen und Regelungen und erörtert die ethischen Herausforderungen, die sich in Bezug auf den Einsatz von bildgebenden Verfahren im Rahmen der medizinischen Heilbehandlung und klinischen Forschung sowie im Kontext des Strafrechts stellen.

Dabei werden insbesondere die Risiko-Nutzen-Bilanz, die Autonomie von Patient:innen, der Schutz ihrer Privatsphäre sowie allgemeinere Überlegungen zur Gerechtigkeit in der klinischen Forschung in den Blick genommen.

Die Erklärbarkeit von künstlicher Intelligenz (KI) in der Medizin ist ein heiß diskutiertes Thema. In unserem Beitrag werden die wichtigsten Argumente für und gegen die Erklärbarkeit von KI-gestützten klinischen Entscheidungsunterstützungssystemen (Clinical Decision Support System, CDSS) anhand eines konkreten Anwendungsfalls untersucht, nämlich eines KI-gestützten CDSS, das derzeit im Rahmen von Notrufen zur Identifizierung von PatientInnen mit lebensbedrohlichem Herzstillstand eingesetzt wird. Genauer gesagt haben wir eine normative Analyse unter Verwendung soziotechnischer Szenarien durchgeführt, um die Rolle der Erklärbarkeit von CDSSs für den konkreten Anwendungsfall nuanciert darzustellen und Abstraktionen auf eine allgemeinere Ebene zu ermöglichen. Unsere Analyse konzentrierte sich auf drei Ebenen: technische Überlegungen, menschliche Faktoren und die vorgesehene Rolle des Systems bei der Entscheidungsfindung. Unsere Ergebnisse deuten darauf hin, dass die Frage, ob die Erklärbarkeit einen Mehrwert für CDSS bieten kann, von mehreren Schlüsselfragen abhängt: der technischen Machbarkeit, dem Grad der Validierung im Falle von erklärbaren Algorithmen, den Merkmalen des Kontexts, in dem das System implementiert wird, der vorgesehenen Rolle im Entscheidungsprozess und der/den wichtigsten Nutzergruppe(n). Daher ist für jedes CDSS eine individuelle Bewertung des Erklärungsbedarfs erforderlich, und wir geben ein Beispiel dafür, wie eine solche Bewertung in der Praxis aussehen könnte.

Werden Neurowissenschaftler dank der bildgebenden Verfahren des Gehirns bald Gedanken lesen können? Wir können diese Frage nicht beantworten, ohne den Stand der Technik in der Neurobildgebung zu kennen. Aber wir können diese Frage auch nicht beantworten, ohne ein gewisses Verständnis des Konzepts zu haben, auf das sich der Begriff „Gedankenlesen“ bezieht. Dieser Artikel ist ein Versuch, ein solches Verständnis zu entwickeln. Unsere Analyse erfolgt in zwei Schritten. In der ersten Phase liefern wir eine kategorische Erklärung des Gedankenlesens. Die kategoriale Erklärung formuliert empirische Bedingungen, die erfüllt sein müssen, damit Gedankenlesen möglich ist. In der zweiten Phase entwickeln wir einen Maßstab für die Beurteilung der Leistungsfähigkeit von Experimenten zum Gedankenlesen. Die sich daraus ergebende Konzeption des Gedankenlesens trägt dazu bei, volkspsychologische Einschätzungen darüber, was Gedankenlesen beinhalten muss, mit den Einschränkungen zu vereinbaren, die sich aus empirischen Strategien zur Erreichung dieses Ziels ergeben.

In diesem Beitrag befassen wir uns mit der Frage, ob KI zur Suizidprävention auf der Grundlage von Social-Media-Daten eingesetzt werden sollte. Wir konzentrieren uns auf Algorithmen, die Personen mit Suizidgedanken auf der Grundlage ihrer Postings auf Social-Media-Plattformen identifizieren können, und untersuchen, ob private Unternehmen wie Facebook berechtigt sind, diese einzusetzen. Um herauszufinden, ob dies der Fall ist, stellen wir zunächst zwei Beispiele für KI-basierte Mittel zur Suizidprävention in sozialen Medien vor. Anschließend stellen wir die Suizidprävention als eine Frage der Wohltätigkeit dar, entwickeln zwei fiktive Fälle, um die Reichweite des Wohltätigkeitsprinzips zu untersuchen, und wenden die gewonnenen Erkenntnisse auf Facebooks Einsatz von KI zur Suizidprävention an. Wir zeigen, dass Facebook weder nach dem Prinzip der Wohltätigkeit noch nach dem des Verdienstes handelt. Diese Erkenntnis führt uns zu der allgemeinen Frage, wer das Recht auf Hilfe hat. Wir kommen zu dem Schluss, dass private Unternehmen wie Facebook eine wichtige Rolle bei der Suizidprävention spielen können, wenn sie sich an bestimmte Regeln halten, die wir aus Wohltätigkeit und Autonomie als Kernprinzipien der biomedizinischen Ethik ableiten. Gleichzeitig sind öffentliche Stellen in der Pflicht, geeignete Rahmenbedingungen für KI-basierte Instrumente der Suizidprävention zu schaffen. Als Ausblick stellen wir dar, wie die Zusammenarbeit zwischen öffentlichen und privaten Institutionen einen wichtigen Beitrag zur Suizidbekämpfung leisten und auf diese Weise das Prinzip der Wohltätigkeit in die Praxis umsetzen kann.

In diesem Beitrag untersuche ich, ob der Einsatz von künstlicher Intelligenz (KI) und automatisierter Entscheidungsfindung (ADM) das Problem der Diskriminierung verschärft, wie von mehreren Autoren behauptet wird. Zu diesem Zweck greife ich zunächst die lebhafte philosophische Debatte über Diskriminierung auf und lege meine eigene Definition des Begriffs vor. Ausgestattet mit dieser Definition werde ich anschließend einige der neueren Literatur über den Einsatz von KI/ADM und Diskriminierung prüfen. Ich erkläre, wie meine Darstellung von Diskriminierung dazu beiträgt zu verstehen, dass die allgemeine Behauptung im Hinblick auf die Verschärfung von Diskriminierung nicht gerechtfertigt ist. Abschließend argumentiere ich, dass der Einsatz von AI/ADM tatsächlich zu einer Verschärfung von Diskriminierung führen kann, allerdings auf eine andere Art und Weise, als die meisten KritikerInnen annehmen: Aufgrund ihrer epistemischen Undurchsichtigkeit droht AI/ADM unsere moralischen Überlegungen zu untergraben, die für ein gemeinsames Verständnis dessen, was als Diskriminierung gelten soll, unerlässlich sind. Infolgedessen stellt sich heraus, dass Algorithmen tatsächlich dabei helfen können, versteckte Formen der Diskriminierung aufzudecken.

Alkoholmissbrauch in der Adoleszenz (AAM) wird mit einer gestörten Entwicklung des jugendlichen Gehirns in Verbindung gebracht. In dieser Längsschnittstudie mit maschinellem Lernen (ML) konnten wir AAM anhand der Gehirnstruktur (T1-gewichtete Bildgebung und DTI) mit einer Genauigkeit von 73-78 % im IMAGEN-Datensatz (n∼1182) vorhersagen. Unsere Ergebnisse zeigen nicht nur, dass strukturelle Unterschiede im Gehirn AAM vorhersagen können, sondern legen auch nahe, dass solche Unterschiede dem AAM-Verhalten in den Daten vorausgehen könnten. Wir haben 10 Phänotypen von AAM im Alter von 22 Jahren anhand von MRT-Merkmalen des Gehirns im Alter von 14, 19 und 22 Jahren vorhergesagt. Saufgelage erwiesen sich als der am besten vorhersagbare Phänotyp. Die aufschlussreichsten Hirnmerkmale befanden sich im ventrikulären Liquor und in den Bahnen der weißen Substanz des Corpus Callosum, der inneren Kapsel und des Hirnstamms. Im Kortex waren sie über den Okzipital-, Frontal- und Temporallappen sowie den cingulären Kortex verteilt. Wir experimentierten auch mit vier verschiedenen ML-Modellen und mehreren Techniken zur Kontrolle von Störfaktoren. Support Vector Machine (SVM) mit rbf-Kernel und Gradient Boosting schnitten durchweg besser ab als die linearen Modelle, lineare SVM und logistische Regression. Unsere Studie zeigt auch, dass die Wahl des vorhergesagten Phänotyps, des ML-Modells und der Confound-Korrekturtechnik entscheidende Entscheidungen in einer explorativen ML-Studie zur Analyse psychiatrischer Störungen mit kleinen Effektgrößen wie AAM sind.

Die Vorhersage von Rückfällen bei Personen mit psychotischen Störungen ist nicht gut etabliert, insbesondere nach Absetzen einer antipsychotischen Behandlung. Unser Ziel war es, mit Hilfe von maschinellem Lernen allgemeine prognostische Faktoren für einen Rückfall bei allen Teilnehmern (unabhängig von der Fortführung oder dem Abbruch der Behandlung) und spezifische Prädiktoren für einen Rückfall bei Abbruch der Behandlung zu ermitteln.

Deep Learning erfordert große beschriftete Datensätze, die in der medizinischen Bildgebung aufgrund von Datenschutzproblemen und zeitaufwändiger manueller Beschriftung schwer zu erfassen sind. Generative Adversarial Networks (GANs) können diese Herausforderungen mildern und die Synthese von gemeinsam nutzbaren Daten ermöglichen. Während 2D-GANs zur Generierung von 2D-Bildern mit den entsprechenden Beschriftungen verwendet wurden, können sie die volumetrischen Informationen der medizinischen 3D-Bildgebung nicht erfassen. 3D-GANs sind hierfür besser geeignet und wurden zur Generierung von 3D-Volumina, aber nicht der entsprechenden Beschriftungen eingesetzt. Ein Grund dafür könnte sein, dass die Synthese von 3D-Volumina aufgrund von Berechnungsbeschränkungen eine Herausforderung darstellt. In dieser Arbeit stellen wir 3D-GANs für die Generierung von 3D-Volumina medizinischer Bilder mit entsprechenden Beschriftungen vor, wobei wir gemischte Präzision anwenden, um Rechenbeschränkungen zu verringern.

Wir generierten 3D Time-of-Flight Magnetresonanz-Angiographie (TOF-MRA) Patches mit den entsprechenden Blutgefäßsegmentierungen des Gehirns. Wir verwendeten vier Varianten von 3D Wasserstein GAN (WGAN) mit: 1) Gradientenstrafe (GP), 2) GP mit spektraler Normalisierung (SN), 3) SN mit gemischter Präzision (SN-MP) und 4) SN-MP mit Doppelfiltern pro Schicht (c-SN-MP). Die erzeugten Patches wurden quantitativ mit Hilfe der Fréchet Inception Distance (FID) und Precision and Recall of Distributions (PRD) bewertet. Des Weiteren wurden 3D-U-Netze mit Patch-Label-Paaren aus verschiedenen WGAN-Modellen trainiert und ihre Leistung mit der Leistung eines Benchmark-U-Netzes verglichen, das mit echten Daten trainiert wurde. Die Segmentierungsleistung aller U-Netz-Modelle wurde anhand des Dice Similarity Coefficient (DSC) und der Balanced Average Hausdorff Distance (bAVD) für a) alle Gefäße und b) nur für intrakranielle Gefäße bewertet.

Unsere Ergebnisse zeigen, dass Patches, die mit WGAN-Modellen mit gemischter Präzision (SN-MP und c-SN-MP) erzeugt wurden, die niedrigsten FID-Scores und die besten PRD-Kurven lieferten. Unter den 3D-U-Netzen, die mit synthetischen Patch-Label-Paaren trainiert wurden, erreichten c-SN-MP-Paare die höchste DSC (0,841) und die niedrigste bAVD (0,508) im Vergleich zum Benchmark-U-Netz, das auf realen Daten trainiert wurde (DSC 0,901; bAVD 0,294) für intrakranielle Gefäße.

Zusammenfassend lässt sich sagen, dass unsere Lösung realistische 3D TOF-MRA-Felder und Beschriftungen für die Segmentierung von Hirngefäßen erzeugt. Wir demonstrieren den Vorteil der Verwendung von gemischter Präzision für die Berechnungseffizienz, was zu der leistungsfähigsten GAN-Architektur führt. Unsere Arbeit ebnet den Weg für die gemeinsame Nutzung von beschrifteten medizinischen 3D-Daten, was die Verallgemeinerbarkeit von Deep-Learning-Modellen für den klinischen Einsatz erhöhen würde.

Im vorliegenden Artikel untersuchen wir die anthropologischen Implikationen „intelligenter“ Neurotechnologien (INT). Dazu geben wir zunächst eine Einführung in die aktuellen Entwicklungen von INT, indem wir deren zentrale Charakteristika benennen. Anschließend stellen wir traditionelle anthropologische Konzepte wie den „Homo faber“, das Konzept des Menschen als „Defizitwesen“ und das Konzept des „Cyborg“ vor, diskutieren diese und hinterfragen ihre deskriptive Relevanz im Hinblick auf aktuelle neurotechnologische Anwendungen. Zu diesem Zweck setzen wir diese anthropologischen Konzepte in Beziehung zu den zuvor erarbeiteten Charakteristika von INT. Wie wir zeigen, variiert die Erklärungsvalidität der in diesem Artikel analysierten anthropologischen Konzepte erheblich. Während das Konzept des Homo faber beispielsweise nicht in der Lage ist, die anthropologischen Implikationen neuer INTs angemessen zu beschreiben, erweist sich der Cyborg als in der Lage, mehrere Aspekte heutiger Neurotechnologien zu erfassen. Dennoch bedarf es alternativer Erklärungsmodelle, um die neuen Charakteristika von INTs in ihrer vollen Komplexität zu erfassen.

An essential component of human-machine interaction (HMI) is the information exchanged between humans and machines to achieve specific effects in the world or in the interacting machines and/or humans. However, such information exchange in HMI may also shape the beliefs, norms and values of involved humans. Thus, ultimately, it may shape not only individual values, but also societal ones. This article describes some lines of development in HMI, where significant value changes are already emerging. For this purpose, we introduce the general notion of eValuation, which serves as a starting point for elaborating three specific forms of value change, namely deValuation, reValuation and xValuation. We explain these along with examples of self-tracking practices and the use of social robots.

Folgen Sie uns auch auf LinkedIn und Instagram und

erhalten Sie regelmäßig die neuesten Informationen, spannende Updates und exklusive Einblicke aus der Welt der Neuroethik.